NV40: новая революция или работа NVIDIA над ошибками NV35? Часть 1

NV40: новая революция или работа NVIDIA над ошибками NV35? Часть 1

"Пока космические корабли бороздят просторы вселенной…" Примерно так можно было начать обзор по графическому процессору нового поколения от NVIDIA. Загадочное "NV40" было на слуху уже давно, и все просто не могли дождаться официального анонса чипа, чтобы воочию убедиться в том, что на этот раз NVIDIA превзошла самое себя. Обрывки фраз о производительности, выросшей в 2 раза по сравнению с предыдущим топовым решением компании, воспринимались видавшими виды тестерами и опытными пользователями со здоровой долей скептицизма, но, тем не менее, то и дело проскальзывала мысль: "А вдруг?"

"Пока космические корабли бороздят просторы вселенной…" Примерно так можно было начать обзор по графическому процессору нового поколения от NVIDIA. Загадочное "NV40" было на слуху уже давно, и все просто не могли дождаться официального анонса чипа, чтобы воочию убедиться в том, что на этот раз NVIDIA превзошла самое себя. Обрывки фраз о производительности, выросшей в 2 раза по сравнению с предыдущим топовым решением компании, воспринимались видавшими виды тестерами и опытными пользователями со здоровой долей скептицизма, но, тем не менее, то и дело проскальзывала мысль: "А вдруг?"

Дотошный читатель наверняка может отметить, что в заголовке статьи значится не NV30, а NV35. Почему же именно он? Все достаточно просто, если вспомнить, что NV35 является сам по себе "работой над ошибками" весьма неудачного чипа NV30. Если мысленно нарисовать себе в памяти таких "динозавров" инженерной мысли NVIDIA=), то именно начиная с них у NVIDIA был в целом немного неудачный период в производственной жизни. Нам кажется, не будет большим преувеличением сказать, что по большому счету вся серия GeForce FX (которая вместо порядкового номера GeForce 5 носила гордый суффикс "FX") получилась у NVIDIA откровенно неудачной. Во-первых, вспомним то, что пальму первенства у графического процессора NVIDIA отнял и не дал быть первым GPU для DirectX 9.0 продукт ATI — ATI Radeon 9700 Pro. Во-вторых, наспех сооруженная панацея в лице NVIDIA GeForce FX 5800 Ultra имела местами весьма существенные оплошности в архитектуре, в-третьих, DDR II память грелась, как печка. И, наконец, в-четвертых, громоздкая система охлаждения, сравнимая разве что с советским пылесосом времен вашей и моей бабушки, не давала заснуть не только вам, так еще и вашим соседям. Все эти минусы в большинстве своем были исправлены в уже упоминавшемся чипе NV35. Однако не были исправлены общие огрехи архитектуры NVIDIA GeForce FX. Ведь как это было ни странно, но ответ NVIDIA на DirectX 9.0 решение от ATI катастрофически медленно работал с основными нововведениями DirectX 9.0 — пиксельными и вершинными программами версии 2.0, которые сулили разработчикам игр возможность создания кинематографических эффектов в своих игровых приложениях, а также прочие радости для программистов. Это не было исправлено на аппаратном уровне, и за дело взялись программисты NVIDIA, которые сутками напролет вручную оптимизировали драйверы Detonator, а затем ForceWare (с переработанным компилятором шейдерного кода) под все новые выходящие игры (в особенности те, которые содержали встроенные инструменты по измерению производительности графической подсистемы компьютера), а также синтетические и полусинтетические приложения (чего стоит один только скандал с FutureMark и их 3DMark 2003).

Видимо, считая, что у GeForce FX плохая карма, NVIDIA решила сменить топологию названий и вместо суффикса FX (на который, видимо, благополучно и "спихнули" плохую карму всей серии) решили использовать старую добрую маркировку, известную еще с GeForce 1-4. Ныне серия называется NVIDIA GeForce FX6800 и на данный момент включает в себя 2 видеокарты на базе новейшего чипа компании NVIDIA — NV40: NVIDIA GeForce FX 6800 Ultra и NVIDIA GeForce FX 6800.

NVIDIA не побоялась снова начать маркировать свои топовые чипы с цифры 800 (вспомним откровенно неудачный NVIDIA GeForce FX 5800 Ultra). Хотя, возможно, это снова задел на будущее, в котором вновь придется проделать "работу над ошибками" в виде NVIDIA GeForce FX 6900=). Зато суффикса FX уже нет. Что же представляет собой новое решение от NVIDIA? Давайте попытаемся ответить на этот вопрос, проанализировав все те технологические новшества, которые несет с собой эта новинка.

Технические характеристики NV40 aka GeForce 6

Дабы более наглядно оценить технические характеристики нового процессора от NVIDIA, мы предлагаем нашим уважаемым читателям проанализировать таблицу, в которой собраны технические характеристики как самого процессора нового поколения от NVIDIA, так и его предшественника в лице NVIDIA GeForce FX 5950 Ultra и его прямого конкурента ATI Radeon 9800XT.

Характеристики NV40 действительно поражают воображение. Только посмотрите на основные характеристики чипа, которые отвечают за общую производительность акселератора в целом! Количество пиксельных конвейеров возросло по сравнению с предыдущим поколением ровно в 2 раза! Теперь чип от NVIDIA имеет целых 16 пиксельных конвейеров рендеринга. Однако скорость закраски должна поддерживаться хорошим блоком построения геометрии. Как с этим обстоят дела? И снова — просто замечательно. Количество вершинных процессоров снова увеличено в 2 раза по сравнению с предыдущим топовым чипом компании. Теперь у NVIDIA GeForce 6800 Ultra их целых 6. Также обращает на себя внимание максимально возможный объем видеопамяти. Он равен 512 Мб. Откровенно говоря, у нас есть некоторые сомнения в целесообразности установки такого объема видеопамяти на видеокарты, построенные на базе пусть даже такого мощного чипа, как NVIDIA GeForce 6800 Ultra. Потребности современных игровых приложений пока еще весьма далеки от возможностей выпускающихся в свет ускорителей. Такова во многом основная актуальная дилемма развития 3D: то, что уже воплощено в железе, еще не скоро будет реализовано программистами в своих продуктах. Наши слова отчасти подтверждаются тем, что тестовые сэмплы NV40, которые были разосланы многим обозревателям по всему миру, оборудованы 256 Мб памяти.

И сразу же на смену DDR I пришла память DDR III. Почему благополучно пропустили DDR II? Все достаточно легко объяснимо, если учесть, что проба DDR II уже состоялась как у NVIDIA, так и у ATI. Результаты оказались не особо хороши — память требовала к себе весьма пристального внимания по части обеспечения надлежащего охлаждения. Модули грелись ощутимо. У NVIDIA DDR II была использована в платах на базе многострадального чипа NV30, а позже — на платах с чипом NV36 aka NVIDIA GeForce FX 5700 Ultra. ATI же применяла DDR II для своих когда-то топовых карт на базе чипа ATI Radeon 9800 Pro, но затем обе компании отказались от данного типа памяти и пришли к общему знаменателю в виде DDR I. Сказать, что рассматриваемый сегодня NV40 использует память стандарта DDR III первым в индустрии, нельзя. Пальму первенства в данном случае держит, как ни странно, плата на базе графического чипа NVIDIA GeForce FX 5700 Ultra — первой увидела свет с памятью DDR III модификация именно этой платы. А использование прогрессивной DDR III памяти позволило, в свою очередь, значительно повысить тактовые частоты работы памяти. Эффективная частота видеопамяти перешагнула за гигагерц и составила 1100 МГц. Соответственно, пропускная способность шины памяти возросла до 32,8 Гб/сек.

Естественно, что возросшие в 2 раза основные тактико-технические характеристики графического процессора не могли не сказаться на количестве транзисторов, которые используются при изготовлении чипа. Их количество смело можно назвать рекордным — примерно 220 млн транзисторов. Это ровно на 100 млн транзисторов больше, чем в предыдущем чипе NVIDIA — GeForce FX 5950 Ultra. Если провести кое-какие параллели с центральными процессорами для настольных систем, то мы можем, к примеру, сказать, что количество транзисторов в NVIDIA GeFor-ce 6800 Ultra практически в 2 раза больше, чем, скажем, в Athlon 64 FX. Как вам это нравится? Постепенно мы дождались того момента, когда количество транзисторов в графических процессорах уже в 2 раза больше, чем в центральном процессоре, а ведь все мы с вами прекрасно помним времена, когда графические процессоры и процессорами-то как таковыми не назывались, а были простыми скромными акселераторами.

Также хочется отметить пугающую многих пользователей потребность NVIDIA GeForce FX 6800 Ultra в 480 Вт блоке питания с двумя свободными линиями питания, которая не была отражена в сравнительной таблице спецификаций, но напрямую вытекает из рекордного количества транзисторов в чипе NVIDIA GeForce FX 6800 Ultra. Как оказалось на практике, карту можно эксплуатировать и в стандартных 300 Вт корпусах, но это чревато последствиями, поэтому данный вопрос пока остается открытым до появления серийно выпущенных NVIDIA GeForce FX 6800 Ultra.

Интерфейс передачи данных сохранился. Это AGP 3.0 (он же AGP 8x). В связи с этим позволим себе высказать определенные сомнения относительно перспектив весьма активно продвигаемого в последнее время стандарта PCI Express. Все же, как и ожидалось, пропускной способности старой доброй шины AGP хватает, чтобы даже такой мощный графический чип, как NVIDIA GeForce FX 6800 Ultra, чувствовал себя прекрасно в плане передачи и получения данных. Да, у PCI Express есть неоспоримые преимущества, но залог успеха нового стандарта обеспечен только в том случае, если его поддержат как ведущие производители процессоров/платформ, так и оба ключевых игрока на рынке графических чипов — ATI и NVIDIA.

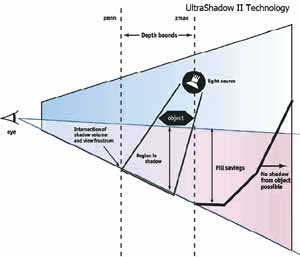

UltraShadow II: насколько важны "правильные" тени?

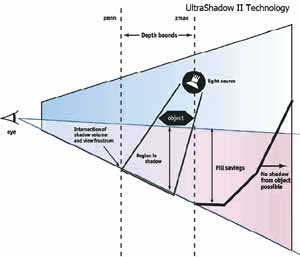

Технология UltraShadow впервые была реализована в графическом процессоре NVIDIA GeForce FX 5900 Ultra. Она заключалась в интеллектуальном обсчете световых источников, что позволяло экономить на вычислениях и повышать производительность в сценах, использующих расчет теней в реальном времени. Нельзя сказать, что данная технология получила огромное распространение. Из просмотренных за последний год игр на ум приходит только X2, где использовались стенсильные (трафаретные) тени, которые и являются продуктом технологии UltraShadow.

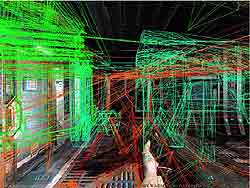

Однако у этой технологии еще все впереди — широчайшее ее использование мы сможем наблюдать в детище Джона Кармака — в его ставшем легендой еще до рождения DooM III. Тени в этой игре будут строиться именно с использованием возможностей технологии UltraShadow. Не зря при демонстрации возможностей идейного продолжения данной технологии в NV40 в лице UltraShadow II NVIDIA приводит примеры из DooM III.

В примерах, представленных в презентации NVIDIA, хорошо заметно, что сцена, использующая UltraShadow II, требует значительно меньшего числа проходов для рендеринга, нежели сцена, построенная без учета возможностей этой технологии.

Сегодня мы рассмотрели технические характеристики нового чипа от NVIDIA. Как вы могли убедиться, они поистине впечатляющие. Сказать, что NV40 — это наиболее технологичное решение NVIDIA на сегодня — значит, ничего не сказать. От одного только числа транзисторов на чипе становится жарко.

В следующем номере мы рассмотрим вопрос о пиксельных шейдерах 3.0 в контексте выпуска NV40, а также множество других интересных вопросов.

Продолжение следует.

Бурдыко Алексей aka Knes, Knes@tut.by

Дотошный читатель наверняка может отметить, что в заголовке статьи значится не NV30, а NV35. Почему же именно он? Все достаточно просто, если вспомнить, что NV35 является сам по себе "работой над ошибками" весьма неудачного чипа NV30. Если мысленно нарисовать себе в памяти таких "динозавров" инженерной мысли NVIDIA=), то именно начиная с них у NVIDIA был в целом немного неудачный период в производственной жизни. Нам кажется, не будет большим преувеличением сказать, что по большому счету вся серия GeForce FX (которая вместо порядкового номера GeForce 5 носила гордый суффикс "FX") получилась у NVIDIA откровенно неудачной. Во-первых, вспомним то, что пальму первенства у графического процессора NVIDIA отнял и не дал быть первым GPU для DirectX 9.0 продукт ATI — ATI Radeon 9700 Pro. Во-вторых, наспех сооруженная панацея в лице NVIDIA GeForce FX 5800 Ultra имела местами весьма существенные оплошности в архитектуре, в-третьих, DDR II память грелась, как печка. И, наконец, в-четвертых, громоздкая система охлаждения, сравнимая разве что с советским пылесосом времен вашей и моей бабушки, не давала заснуть не только вам, так еще и вашим соседям. Все эти минусы в большинстве своем были исправлены в уже упоминавшемся чипе NV35. Однако не были исправлены общие огрехи архитектуры NVIDIA GeForce FX. Ведь как это было ни странно, но ответ NVIDIA на DirectX 9.0 решение от ATI катастрофически медленно работал с основными нововведениями DirectX 9.0 — пиксельными и вершинными программами версии 2.0, которые сулили разработчикам игр возможность создания кинематографических эффектов в своих игровых приложениях, а также прочие радости для программистов. Это не было исправлено на аппаратном уровне, и за дело взялись программисты NVIDIA, которые сутками напролет вручную оптимизировали драйверы Detonator, а затем ForceWare (с переработанным компилятором шейдерного кода) под все новые выходящие игры (в особенности те, которые содержали встроенные инструменты по измерению производительности графической подсистемы компьютера), а также синтетические и полусинтетические приложения (чего стоит один только скандал с FutureMark и их 3DMark 2003).

Видимо, считая, что у GeForce FX плохая карма, NVIDIA решила сменить топологию названий и вместо суффикса FX (на который, видимо, благополучно и "спихнули" плохую карму всей серии) решили использовать старую добрую маркировку, известную еще с GeForce 1-4. Ныне серия называется NVIDIA GeForce FX6800 и на данный момент включает в себя 2 видеокарты на базе новейшего чипа компании NVIDIA — NV40: NVIDIA GeForce FX 6800 Ultra и NVIDIA GeForce FX 6800.

NVIDIA не побоялась снова начать маркировать свои топовые чипы с цифры 800 (вспомним откровенно неудачный NVIDIA GeForce FX 5800 Ultra). Хотя, возможно, это снова задел на будущее, в котором вновь придется проделать "работу над ошибками" в виде NVIDIA GeForce FX 6900=). Зато суффикса FX уже нет. Что же представляет собой новое решение от NVIDIA? Давайте попытаемся ответить на этот вопрос, проанализировав все те технологические новшества, которые несет с собой эта новинка.

Технические характеристики NV40 aka GeForce 6

Дабы более наглядно оценить технические характеристики нового процессора от NVIDIA, мы предлагаем нашим уважаемым читателям проанализировать таблицу, в которой собраны технические характеристики как самого процессора нового поколения от NVIDIA, так и его предшественника в лице NVIDIA GeForce FX 5950 Ultra и его прямого конкурента ATI Radeon 9800XT.

Характеристики NV40 действительно поражают воображение. Только посмотрите на основные характеристики чипа, которые отвечают за общую производительность акселератора в целом! Количество пиксельных конвейеров возросло по сравнению с предыдущим поколением ровно в 2 раза! Теперь чип от NVIDIA имеет целых 16 пиксельных конвейеров рендеринга. Однако скорость закраски должна поддерживаться хорошим блоком построения геометрии. Как с этим обстоят дела? И снова — просто замечательно. Количество вершинных процессоров снова увеличено в 2 раза по сравнению с предыдущим топовым чипом компании. Теперь у NVIDIA GeForce 6800 Ultra их целых 6. Также обращает на себя внимание максимально возможный объем видеопамяти. Он равен 512 Мб. Откровенно говоря, у нас есть некоторые сомнения в целесообразности установки такого объема видеопамяти на видеокарты, построенные на базе пусть даже такого мощного чипа, как NVIDIA GeForce 6800 Ultra. Потребности современных игровых приложений пока еще весьма далеки от возможностей выпускающихся в свет ускорителей. Такова во многом основная актуальная дилемма развития 3D: то, что уже воплощено в железе, еще не скоро будет реализовано программистами в своих продуктах. Наши слова отчасти подтверждаются тем, что тестовые сэмплы NV40, которые были разосланы многим обозревателям по всему миру, оборудованы 256 Мб памяти.

И сразу же на смену DDR I пришла память DDR III. Почему благополучно пропустили DDR II? Все достаточно легко объяснимо, если учесть, что проба DDR II уже состоялась как у NVIDIA, так и у ATI. Результаты оказались не особо хороши — память требовала к себе весьма пристального внимания по части обеспечения надлежащего охлаждения. Модули грелись ощутимо. У NVIDIA DDR II была использована в платах на базе многострадального чипа NV30, а позже — на платах с чипом NV36 aka NVIDIA GeForce FX 5700 Ultra. ATI же применяла DDR II для своих когда-то топовых карт на базе чипа ATI Radeon 9800 Pro, но затем обе компании отказались от данного типа памяти и пришли к общему знаменателю в виде DDR I. Сказать, что рассматриваемый сегодня NV40 использует память стандарта DDR III первым в индустрии, нельзя. Пальму первенства в данном случае держит, как ни странно, плата на базе графического чипа NVIDIA GeForce FX 5700 Ultra — первой увидела свет с памятью DDR III модификация именно этой платы. А использование прогрессивной DDR III памяти позволило, в свою очередь, значительно повысить тактовые частоты работы памяти. Эффективная частота видеопамяти перешагнула за гигагерц и составила 1100 МГц. Соответственно, пропускная способность шины памяти возросла до 32,8 Гб/сек.

Естественно, что возросшие в 2 раза основные тактико-технические характеристики графического процессора не могли не сказаться на количестве транзисторов, которые используются при изготовлении чипа. Их количество смело можно назвать рекордным — примерно 220 млн транзисторов. Это ровно на 100 млн транзисторов больше, чем в предыдущем чипе NVIDIA — GeForce FX 5950 Ultra. Если провести кое-какие параллели с центральными процессорами для настольных систем, то мы можем, к примеру, сказать, что количество транзисторов в NVIDIA GeFor-ce 6800 Ultra практически в 2 раза больше, чем, скажем, в Athlon 64 FX. Как вам это нравится? Постепенно мы дождались того момента, когда количество транзисторов в графических процессорах уже в 2 раза больше, чем в центральном процессоре, а ведь все мы с вами прекрасно помним времена, когда графические процессоры и процессорами-то как таковыми не назывались, а были простыми скромными акселераторами.

Также хочется отметить пугающую многих пользователей потребность NVIDIA GeForce FX 6800 Ultra в 480 Вт блоке питания с двумя свободными линиями питания, которая не была отражена в сравнительной таблице спецификаций, но напрямую вытекает из рекордного количества транзисторов в чипе NVIDIA GeForce FX 6800 Ultra. Как оказалось на практике, карту можно эксплуатировать и в стандартных 300 Вт корпусах, но это чревато последствиями, поэтому данный вопрос пока остается открытым до появления серийно выпущенных NVIDIA GeForce FX 6800 Ultra.

Интерфейс передачи данных сохранился. Это AGP 3.0 (он же AGP 8x). В связи с этим позволим себе высказать определенные сомнения относительно перспектив весьма активно продвигаемого в последнее время стандарта PCI Express. Все же, как и ожидалось, пропускной способности старой доброй шины AGP хватает, чтобы даже такой мощный графический чип, как NVIDIA GeForce FX 6800 Ultra, чувствовал себя прекрасно в плане передачи и получения данных. Да, у PCI Express есть неоспоримые преимущества, но залог успеха нового стандарта обеспечен только в том случае, если его поддержат как ведущие производители процессоров/платформ, так и оба ключевых игрока на рынке графических чипов — ATI и NVIDIA.

UltraShadow II: насколько важны "правильные" тени?

Технология UltraShadow впервые была реализована в графическом процессоре NVIDIA GeForce FX 5900 Ultra. Она заключалась в интеллектуальном обсчете световых источников, что позволяло экономить на вычислениях и повышать производительность в сценах, использующих расчет теней в реальном времени. Нельзя сказать, что данная технология получила огромное распространение. Из просмотренных за последний год игр на ум приходит только X2, где использовались стенсильные (трафаретные) тени, которые и являются продуктом технологии UltraShadow.

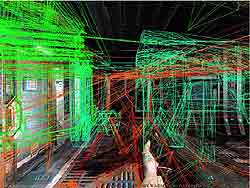

Однако у этой технологии еще все впереди — широчайшее ее использование мы сможем наблюдать в детище Джона Кармака — в его ставшем легендой еще до рождения DooM III. Тени в этой игре будут строиться именно с использованием возможностей технологии UltraShadow. Не зря при демонстрации возможностей идейного продолжения данной технологии в NV40 в лице UltraShadow II NVIDIA приводит примеры из DooM III.

В примерах, представленных в презентации NVIDIA, хорошо заметно, что сцена, использующая UltraShadow II, требует значительно меньшего числа проходов для рендеринга, нежели сцена, построенная без учета возможностей этой технологии.

Сегодня мы рассмотрели технические характеристики нового чипа от NVIDIA. Как вы могли убедиться, они поистине впечатляющие. Сказать, что NV40 — это наиболее технологичное решение NVIDIA на сегодня — значит, ничего не сказать. От одного только числа транзисторов на чипе становится жарко.

В следующем номере мы рассмотрим вопрос о пиксельных шейдерах 3.0 в контексте выпуска NV40, а также множество других интересных вопросов.

Продолжение следует.

Бурдыко Алексей aka Knes, Knes@tut.by

Компьютерная газета. Статья была опубликована в номере 26 за 2004 год в рубрике hard :: video